Blog

Blog

Tendencias de extracción de datos en máquinas y aplicaciones…

Extraer datos de diversas aplicaciones remotas con el fin de controlar, optimizar y aumentar la eficiencia de activos y procesos productivos en búsqueda de un aumento en la rentabilidad, hace años que es una necesidad en el sector industrial.

Partiendo de los primeros Dataloggers, pasando por los PIDs, PLCs, mecanismos de transmisión alámbrica e inalámbrica, RTTY o FSK, y hasta llegar al uso de Internet, redes TSN, malladas y celulares de alta velocidad; todas estas tecnologías persiguen el mismo objetivo, a pesar de que los medios continúen en constante evolución.

La presión competitiva y la aparición de nuevas tendencias ha estimulado el desarrollo de nuevos modelos de negocios basados en los servicios, tales como el renting, sharing, contratos de mantenimiento y servicio (SLA), etc.

Asimismo, el acceso a las múltiples fuentes de información que brinda Internet empodera a los posibles clientes con la capacidad de consultar las experiencias previas de otros usuarios, obtener información en webs, blogs o revisiones de productos de especialistas independientes e, incluso, dejar constancia de su propia experiencia.

Por ese motivo, hoy más que nunca, cuidar y monitorizar el funcionamiento de nuestros productos y soluciones, así como la experiencia de nuestros clientes, es una necesidad fundamental para cualquier negocio.

En este artículo proporcionamos una visión general de los principales pros y contras que ofrecen las distintas tecnologías de extracción de datos de máquinas y procesos, (Datalogging, Telecontrol, Edge, Fog y Cloud Computing) cuyo conocimiento permitirá iniciarse en la gestión remota de activos de una forma ágil y segura.

1. Datalogging

¿Qué es?

El Datalogging permite registrar los datos de los sensores (internos o externos) a los que está conecta el datalogger; un dispositivo externo a la electrónica de control que opera la máquina o aplicación.

Casi todos los dataloggers están basados en microcontroladores. Algunos de ellos están provistos de pantallas LCD, tienen capacidad de ser programados, de gestionar la conectividad remota (serie o ethernet) o cuentan con algunas salidas para actuar. Los dataloggers llevan mucho tiempo en el mercado y suelen ser dispositivos con funciones muy concretas. No obstante, en los últimos años su uso ha comenzado a decrecer, quizás debido a la buena aceptación de dispositivos de red con más funcionabilidades que incorporan la opción de Datalogging.

Pros

- Robustos.

- Sencillos.

- No intervienen en el control de la aplicación.

Contras

- Funcionamiento limitado.

- No cuentan con gestión remota.

- Electrónica y código propietario en la mayoría de los casos.

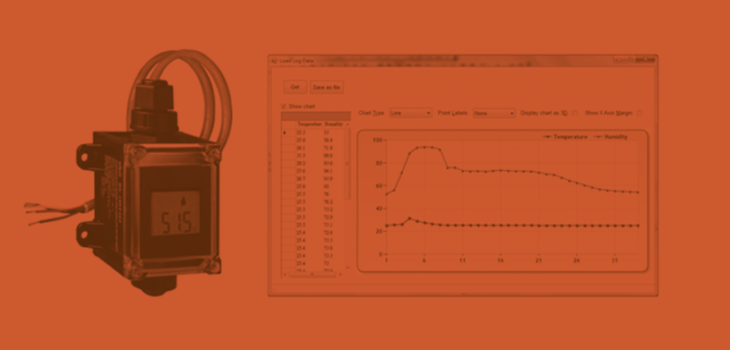

Son sensores IP66 de temperatura y humedad con conectividad Modbus RTU y pantalla LCD, que incorporan un Datalogger con capacidad de hasta 4.088 registros de temperatura y humedad

2. Telecontrol remoto

¿Qué es?

El Telecontrol remoto utiliza protocolos sobre IP para brindar conectividad entre dispositivos que se encuentran en diferentes redes, apoyándose en 3 grupos de servicios básicos: servicios de autentificación de usuarios, tunelado IP y funciones de enrutamiento de red.

Su principal función es permitir a usuarios o sistemas remotos conectarse entre sí o a diferentes dispositivos, como si estuvieran en el mismo segmento de red; con el fin de monitorizar, controlar y mantener los dispositivos desplegados.

Pros

- Ahorro en costes de mantenimiento.

- Servicios de ciberseguridad que ofrecen una conexión cada vez más segura.

- Compatibilidad con múltiples sistemas operativos.

Contras

- Se limita a gestionar sesiones remotas.

- No actúa en local de forma autónoma, depende de la supervisión del operador.

- Carece de una base de datos o registro de los valores representados durante la sesión remota.

3. Edge Computing

¿Qué es?

El término Edge Computing se refiere al tratamiento de datos obtenidos en el mismo sensor o en un dispositivo que se encuentra muy próximo a él (básicamente, en su mismo segmento de red).

Algunos equipos están dotados de características técnicas que les permiten actuar, por lo que el resultado de sus cálculos puede derivar en acciones relacionadas, o no, con otros elementos inteligentes.

Pros

- Mayor autonomía en los dispositivos.

- Menor latencia en la obtención del dato y en la actuación sobre el proceso, permitiendo a los usuarios analizar y actuar casi en tiempo real; una de las principales barreras técnicas de diferentes aplicaciones (coche autónomo, robótica, energía, fabricación automatizada, smart farming, etc.).

- Menor requerimiento de ancho de banda.

- Reducción de costes por concepto de transmisión y recepción de datos.

- Menor consumo eléctrico.

- Menor impacto en el proceso en caso de fallos; solo se afecta la parte que se encuentra supervisada por el dispositivo Edge a cargo (siempre que sean procesos no conectados).

- Aporta más seguridad de forma nativa, debido a la reducción de envío y recepción de datos.

Contras

- Es una arquitectura más compleja de supervisar, mantener y controlar, debido al múltiple número de dispositivos.

4. Fog Computing

¿Qué es?

Fog Computing es un centro de cómputo superior a la capa de sensores/actuadores, pero inferior al Cloud, que se utiliza en SCADAs, ERPs, CRMs, MES, etc. En algunos casos se implementa como capa intermedia entre el Edge y el Cloud y, en otros, funciona solo en local desprovisto de acceso a Internet. Por ejemplo, en un sistema SCADA de una fábrica de medicamentos.

Las soluciones basadas en la nube han mutado hacia a este tipo de arquitecturas, donde existe un coordinador de un nodo o grupo de dispositivos que envían/reciben información, incluyen bases de datos, sistemas de explotación y visualización de la información más avanzados. Muchas veces, cuentan con mayor capacidad de cálculo que los dispositivos pensados para operar como Edge Computing.

Pros

- Los mencionados en la filosofía Edge Computing; sin embargo, tomando en cuenta que es una arquitectura con un coordinador, se debe considerar que:

. Se reduce la autonomía en los dispositivos del nodo.

. La latencia es superior.

. Los requerimientos de ancho de banda pueden ser superiores.

. La reducción de costes por concepto de transmisión y recepción de datos, dependerán del tipo de comunicación con los sensores/actuadores.

. Al existir un concentrador central el consumo eléctrico aumenta.

. El impacto en el proceso en caso de fallos es mayor debido a que varios sensores/actuadores dependen del coordinador (siempre que sean procesos no conectados).

. El nivel de seguridad de forma nativa dependerá de la arquitectura de red y su interacción con el exterior. - Suelen ser arquitecturas modulares que facilitan el desarrollo de aplicaciones complejas y permiten compartir información con diferentes dispositivos y usuarios de forma rápida, robusta, sencilla, escalable y segura.

- Es posible agregar datos provenientes de múltiples fuentes y puntos de la intranet de forma sencilla, enriqueciendo la toma de decisión.

Contras

- Es una arquitectura que requiere supervisar, mantener y controlar, como mínimo, cada concentrador de nodo. Sin embargo, esta no exime la obligación de mantener y controlar los sensores/actuadores.

- Se necesita más infraestructura y, por tanto, más inversión.

- En algunos casos estos sistemas requieren de una licencia de software que supone un coste adicional.

5. Cloud Computing

¿Qué es?

Son centros de cómputo conectados a Internet, que reciben y procesan gran cantidad de información para tomar decisiones y obtener conclusiones. Su alcance es global y sus características le otorgan agilidad, efectividad en costes, escalabilidad, elasticidad y capacidad de operación con múltiples dispositivos y usuarios.

Es importante destacar que el Cloud Computing por sí solo no aporta una solución. Por el contrario, requiere de sensores/actuadores para poder recibir información y actuar sobre el proceso, así como mostrar información al usuario.

Pros

- Reducción en los costes, mediante el alquiler del hardware responsable de realizar los cálculos.

- Facilidad de mantenimiento.

- Mayor potencia de cálculo.

- Simplicidad para compartir información entre elementos de hardware y software.

- Escalabilidad y elasticidad.

- Prestación de servicio a nivel global.

- Rápida implementación.

Contras

- Aumento de la exposición a ciberataques y a la fuga de información.

- Aumento de la latencia.

- Menor autonomía en los dispositivos.

- Interdependencia al proveedor del servicio y a Internet.

- Poca madurez en este tipo de tecnologías que suscitan continuos cambios.

- Incompatibilidad con sistemas redundantes y autónomos.

- Mayor requerimiento de ancho de banda.

- Costes por concepto de transmisión y recepción de datos.

- Mayor consumo eléctrico.

- Impacto en gran parte del proceso en caso de fallos.

Conclusiones

- La evolución y la capacidad de cálculo de los nuevos procesadores, la optimización de los sistemas operativos Linux y la colaboración de los lenguajes Open Source han permitido que el hardware utilizado en las comunicaciones industriales sea cada vez más versátil. Todo ello brinda nuevas funciones que incorporan más protocolos y permitien al usuario realizar explotación de datos en distintos niveles, ofreciendo una óptima relación precio/valor.

- Las posibles combinaciones que se pueden proponer en una arquitectura de equipos para la explotación de datos de una aplicación pueden resultar infinitas y, una mala decisión en este punto implicaría el fracaso o el rotundo éxito en la implementación de un nuevo modelo de negocio o de su optimización.

- Las fronteras entre las diferentes tendencias mencionadas en este artículo son difusas y existen dispositivos que incorporan más de una. Tampoco es posible concebir una arquitectura sin considerar todos los elementos que conforman la solución.

- Existen elementos como la conectividad, la propia aplicación del cliente, dispositivos propietarios, elementos de software, la integración y el mantenimiento que deben de ser tomados en cuenta para la viabilidad del proyecto.

- Si fuese necesario resumir en dos palabras, los elementos necesarios para emprender un proyecto exitoso de Digitalización Industrial, se podría seleccionar Buen Scoping y Partnership.